Ізраїльські спеціалісти обдурили автопілот Tesla й змусили електромобіль з’їхати на умовну зустрічну смугу.

Інженери з університету Бен-Гуріона провели експеримент, щоб показати недосконалість систем допомоги водієві.

Так, з допомогою портативного проектора на деревах та стінах відтворювали несправжні дорожні знаки, які система сприймала за реальні.

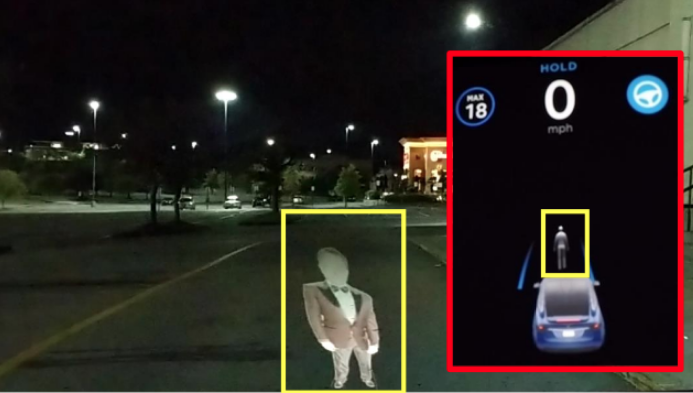

Окрім того, на асфальт проектували пішохода, автомобіль та змінену розмітку. Й у всіх трьох випадках автопілот працював некоректно. У першому випадку автомобіль переїхав проекцію, адже розпізнав її в останній момент і почав екстрено гальмувати. Те ж саме відбулося й з проекцією автомобіля.

А от у випадку із псевдорозміткою автопілот змусив автомобіль звернути на умовну зустрічну смугу.

Спеціалісти наголосили, що результати дослідження викликають занепокоєння. При цьому вони пропонують розробникам систем навчати нейромережі фільтрувати об’єкти й визначати несправжні на підставі контексту їх розташування, відносного розміру, освітлення і текстури, щоб бути захищеними від подібних атак.

«Нездатність систем автопілотування відрізняти фейкові дорожні знаки від справжніх небезпечна тим, що дає можливість зловмисникам викликати різке гальмування певного автомобіля з автопілотом й спровокувати серйозне ДТП», – йдеться в повідомлені.

Як раніше повідомляв Autogeek, засновник Tesla Ілон Маск заявив, що спеціалісти компанії працюють над тим, щоб навчити автопілот електромобілів бренду виявляти вибоїни і ями на дорогах.

За матеріалами: eprint.iacr.org